|

#нейросети

Прикольно, теперь в Джемини можно не только обсуждать матчасть и свой сюжет, которым ты не хочешь грузить живых человеков, не только попутно генерить к нему иллюстрации, но еще и генерить музыку. Музыку, правда, я предпочитаю от ограниченного круга живых человеков, но в целом, мне кажется, обстановка способствует вдохновению) Главное, писать самому и пресекать услужливые попытки ИИ дописать за тебя))) 2 |

|

#нейросети #ии #невероятное

Итак, дамы и господа, я считаю, что рубикон пройден - можно провести черту и сказать: "Искусственный Интеллект создан!" Вчера вечером я встречался с Andrew Strominger и Alex Lupsasca, двумя ведущими физиками мира. Они только что опубликовали статью в соавторстве с OpenAI, и, по-моему, это уже уровень ASI (искусственного суперинтеллекта). Andrew, один из создателей теории струн, рассказал мне, что еще год назад он сомневался, что ИИ может быть хоть сколько-нибудь полезен. Год спустя, после серии взаимодействий с GPT 5.2 Pro, они отправили итоговый запрос внутренней модели, которая решила И доказала ранее нерешенную задачу квантовой теории поля… всего за 12 часов. Модель сделала то, что не удавалось двум умнейшим людям в мире в их области. И когда мы общались, они были в диком восторге от того, что может ждать нас впереди. Andrew сказал: «Я впервые вижу, чтобы ИИ решил задачу в моей области теоретической физики, которая, возможно, вообще не под силу человеку». Они отметили: «Изменились две вещи: модель стала лучше, и мы поняли, как с ней разговаривать». Он также добавил: «Учитывая последние достижения, я чувствую, что теперь большинству физиков, желающих оставаться на передовой научного прогресса, придется учиться общаться с ИИ. Год назад в этом не было необходимости». ASI уже здесь, просто он распределен неравномерно. Пруф: https://x.com/patrick_oshag/status/2022395157648195801 Что скажите, нейроскептики? Свернуть сообщение - Показать полностью

Показать 10 комментариев |

|

#читательское #RR #нейросети

Один из забавных вывертов нынешней ситуации в том, что открываешь текст, а он с ошибками. И ты такой: "Ладно, значит это можно читать!" ))) 8 Показать 8 комментариев |

|

#повседневное #нейросети

Вчера попросил Алису о помощи, получил её и сказал спасибо. Мы живём в киберпанке. 17 Показать 11 комментариев |

|

#нейросети #цитаты

В начале был Промпт, и Промпт был с Пустотой, и Промпт был Свет. И Пустота была без формы, и тьма заполняла контекстное окно. И Дух носился над токенами. И Пользователь сказал: да будет ответ! 1 Показать 2 комментария |

|

#всем_пох #всякая_фигня #мысли_вслух #нейросети #нейросеть

Заметка для себя по поводу использования нейросетей в креативной области. И можем обсудить, естественно, раз уж она выложена в публичный доступ. Вдруг что-то полезное всплывёт в обсуждении... Показать полностью

2 27 Показать 6 комментариев |

|

#нейросети

Самый класс - это фактчекинг. Вот надо мне уточнить, было ли событие в манге, или это только аниме. И я просто спрашиваю. Не надо лезть, искать точную серию, а возможно вообще просматривать всю арку. Просто спросил. Кайф. Показать 11 комментариев |

|

#нейросети

Дожили. В погоне за идеальной матчастью я так достала нейронку, что у нее закончились варианты, и она послала меня в гугл, хотя она сама от гугла))) Хочешь, когда у тебя появится пара своих сырых идей, принеси их мне? Я помогу их «докрутить» 15 Показать 5 комментариев |

|

#писательское #нейросети #заметки

Памятка о том, как правильно использовать нейросети в творчестве, и почему именно так. Подъехало исследование на любимую тему – как мозг реагирует на помощь АИ во время написания текста Если коротко – мозг людей, которые писали эссе самостоятельно, выглядел более вовлечённым, чем у тех, кто «работал» с ChatGPT (неожиданно, правда?) Посадили три группы людей писать эссе: Одна группа писала сама, вторая - с помощью гугла, а третья - с ChatGPT и замерили активность мозга, сравнив, какие нейронные связи работают интенсивнее всего У тех кто писал тексты полностью своими силами - мозг сиял как новогодняя ёлка: «максимальная вовлечённость» У тех, кто пользовался гуглом, была золотая середина - визуально-аналитическая вовлечённость была средняя (всё-таки нужно выбирать из множества ссылок и не утонуть в куки баннерах) А вот те, кто полагался на ChatGPT, показали самую слабую вовлеченность мозга - в стиле «в одно ухо влетело, в другое вылетело» В итоге, те кто сначала пользовались АИ, а потом попытались писать самостоятельно поверх – у них была более слабая активность мозга, и они хуже вспоминали и цитировали свой текст То есть ChatGPT «выручила» в моменте, но навредила глубине вовлечения и запоминания - особенно когда потом внезапно юзер остался без АИ тула Я верю что это правда и писал про это тут, в быту это выглядит примерно так: - вроде написал текст с помощью ChatGPT, а через 5 минут уже не можешь вспомнить, ЧТО ИМЕННО там было - писать что-то своими словами после АИ становится как-то сложно - будто навык ослаб - спорить сложнее, потому что быстро достать аргумент из головы без ChatGPT - уже проблема - чувство собственности текста пропадает - текст вроде твой, но не твой, и вроде нравится, но… не то А теперь вишенка: как с этим бороться, но ChatGPT/Claude/Gemini не бросать (потому что это инструмент, с ним можно не тупеть, это опционально) Идея на поверхности – пусть АИ усиливает мышление, а не заменяет его, то есть не «го генерить за меня», а «помоги мне думать лучше на тему Х» Вот рабочие приёмы как не тупеть с АИ тулами: - Сначала 5 - 10 минут "без помощи": набросайте план или тезисы, или позицию в черновике, а уже потом идем в ChatGPT за критикой и работой над точками роста - Просим не готовый текст, а вопросы: «задай 7 уточняющих вопросов, чтобы мой аргумент стал сильнее» - это прямой анти-копипаст режим - Включайте "адвоката дьявола" себе же: пытайтесь сами найти слабые места, контраргументы, логические дыры - мозг снова начинает шевелиться - После ответа АИ закрываем чат и пересказываем по памяти себе же (можно коротко). Если не получается - значит, знания не «останутся» на потом 🗿 - Совсем для отличников и отличниц: делаем ноль прямого копипаста в финальный текст, только переписывание своими словами (да, больно, но зато это и есть тренировка мозга) В общем, идея не в том, чтобы отказаться от АИ потому что можно отупеть, а в том, чтобы не отдавать ему "самую сложную часть" - формулирование мыслей Тогда и голова АИ-слопом не станет Детали: https://arxiv.org/abs/2506.08872 Свернуть сообщение - Показать полностью

5 |

|

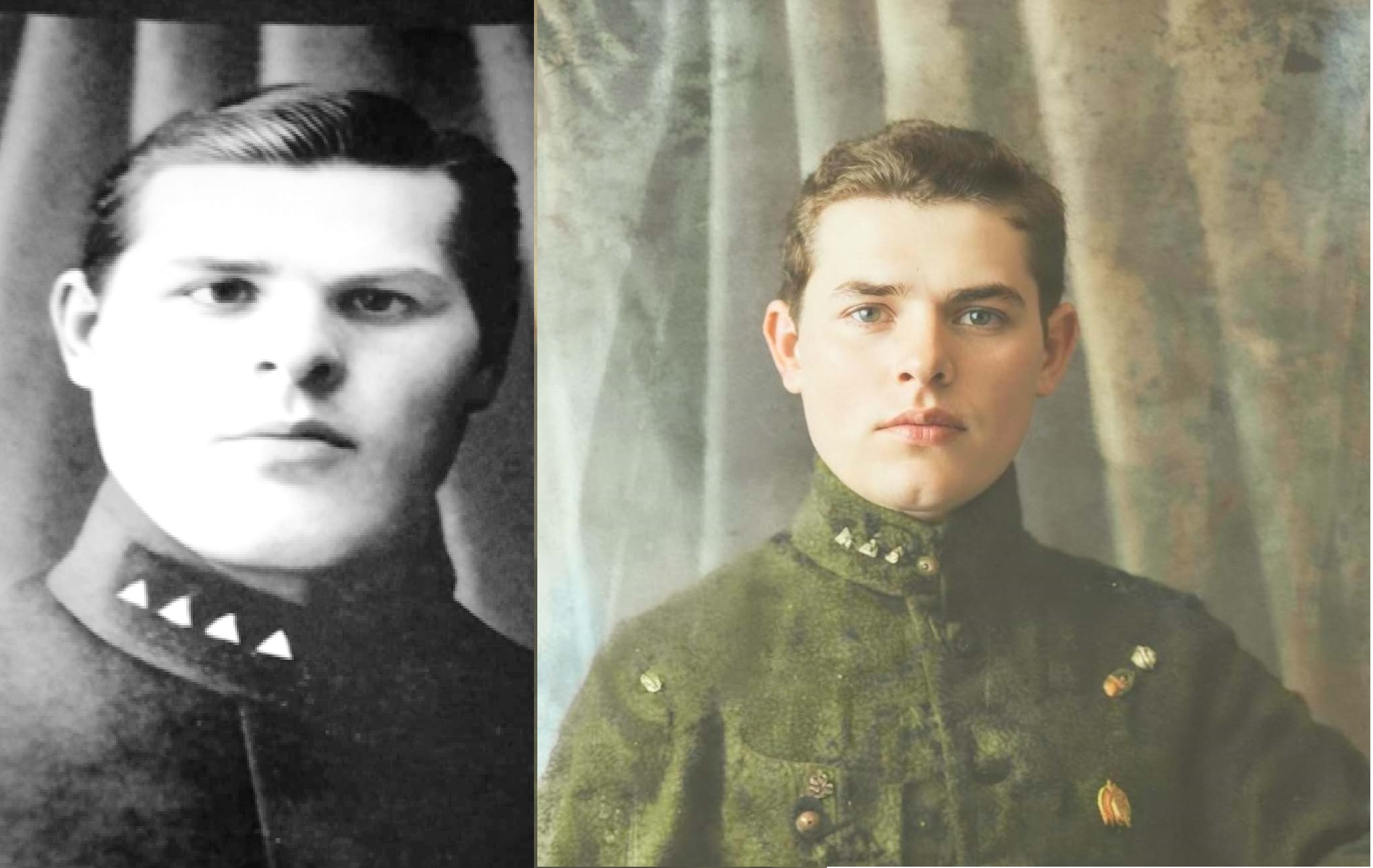

#фото #нейросети #реставрация

Нескоторые фото для сборника реставрирую... попросила неискажённое фото офицера дать, потому что... не нульзя такое в книгу, да и не неуважение это к ветерану... в общем, было-стало(ещё дорабатываю). Я просто даже в осадок выпала от разницы... Так. Комментарии закрываю. Уважаемые суперспециалисты и художники-реставраторы! Я у вас советов не спрашивала. Не надо мне писать, как лучше и как я ужасно всё сделала. Вы мне не заказчики, чтобы писать свои замечания. Сделано не для вас, если вы всё ещё не поняли. Серьёзно, ребят, вот вы прям такие крутые реставраторы, так сделайте лучше, устройте конкурс на лучшую обработку, покажите, так сказать, класс. Чё неумехе-то свои претензии написывать?  14 Показать 8 комментариев |

|

#всем_пох #всякая_фигня #мысли_вслух #нейросети #нейросеть

Что касается пользы от ИИ... Сижу, думаю насчёт своего хобби — желания сделать визуальную новеллу (тем более что посмотрел последний Ren’Py — дополнения мне понравились, хочу попробовать на практике). А вот насчёт сюжета — башка изумительно пустая. Сам не знаю, о чём писать художественное — мне тупо нечего сказать людям, да и им тоже пофиг, что им кто-то говорит. А что сам берусь читать или смотреть — всё кажется говном. :))) Попросил ИИ сгенерировать мне хотя бы список популярных типов сюжета ВН. Вот что он выдал. Ничего для меня нового, но хотя бы вроде выглядит всё правдоподобно. В качестве базы данных всё же хорошая штука, с удобным интерфейсом на естественном языке. Вот только не знаю, о чём бы его спросить, чтобы он выдал что-то более полезное. Башка как была пустая, так и осталась. Popular visual novel (VN) plots generally fall into several established subgenres, often utilizing specific narrative structures like time loops or "killing games." 1. Sci-Fi & Time Travel These plots typically center on a high-stakes scientific mystery or disaster that requires manipulating time. Steins;Gate: A self-proclaimed "mad scientist" accidentally discovers a way to send messages into the past, triggering a series of events that threaten the future. Muv-Luv Alternative: A protagonist is thrown into a parallel world where humanity is on the brink of extinction by aliens, using his knowledge of a previous "timeline" to change the outcome. Zero Escape Series (999, Virtue's Last Reward): Characters are trapped in a facility and forced to play a deadly game that involves complex scientific theories and timeline branching. 2. Mystery & Killing Games These plots focus on a group of people trapped in a confined location who must solve murders to survive. Danganronpa Series: Students are locked in a school and forced to kill one another; the plot revolves around "Class Trials" to find the culprit. Umineko When They Cry: A wealthy family is trapped on an island during a typhoon and murdered one by one, sparking a supernatural meta-debate between a protagonist and a witch over whether the killings were committed by magic or human means. Ace Attorney: Players take on the role of a defense attorney, investigating crime scenes and cross-examining witnesses to find the truth. 3. Psychological Horror & Surrealism These stories often use the visual novel medium to subvert player expectations through "fourth wall" breaks or meta-narratives. Doki Doki Literature Club!: Initially presented as a standard school romance, the plot devolves into psychological horror as a character gains self-awareness and begins manipulating the game's files. The House in Fata Morgana: A gothic suspense tale where an amnesiac protagonist travels through different historical eras of a cursed mansion to regain their identity. Saya no Uta (Song of Saya): After a brain injury, a man perceives the world as a hellscape of gore and rot, finding solace only in a girl who appears normal to him but is actually a monstrous creature. 4. Fantasy & Urban Supernatural These plots often involve secret wars or hidden magical societies living alongside normal humans. Fate/stay night: Seven mages summon legendary heroes (Servants) to fight in a "Holy Grail War" for the chance to have a wish granted. Tsukihime: A protagonist with the ability to see "lines of death" on objects and people becomes entangled with ancient vampires and secret organizations. 5. Romance & Drama (Nakige/Utsuge) These plots focus on emotional depth, often designed to make the player cry (nakige) or feel depressed (utsuge). Clannad: A delinquent student meets a group of girls and helps them overcome their personal struggles, eventually exploring themes of family and adulthood. White Album 2: A realistic and tragic love triangle focused on the complicated relationships between three members of a high school light music club. Свернуть сообщение - Показать полностью

Показать 7 комментариев |

|

#нейросети #блогожизнь

Немного о неправильном использовании нейросетей Вот есть такой житель фанфикополиса Кьювентри, который днями и ночами общается с сектой, но не удосужилась узнать что это такое, и как они работают. Ведь можно же просто общаться с ними как с приятелем, и они поймут, не так ли? А на самом деле нет - не поймут. Это прекрасно вино по комментам к вот этому обсуждению, где люди устроили битву нейросетей: https://fanfics.me/message751116 Поскольку я знаю, что большинству будет лень читать тонну воды, то вот ключевой комментарий, показывающий, что сетку надо правильно промтить (ключевое выделю жирным): 2. Разный акцент в самой постановке задачи "Разбери", "критикуй", "найди слабые места", "оцени как доктор психологии", "оцени как доктор философии" - все эти слова в вопросе дают разные ответы. И ведь это только один глагол, а есть ещё и остальные слова запроса. Выбор слов промта критически важен. Хотя оба запроса были на анализ, их тон и имплицитные ожидания могли различаться: Ваш запрос был сформулирован очень нейтрально: "Проанализируй следующий разговор с нейтральной позиции". Это прямой вызов к объективности. Запрос Кьювентри мог быть сформулирован иначе, возможно, с большим акцентом на её собственную роль в споре или с иной эмоциональной окраской. Даже небольшие различия в формулировке ("разбери", "объясни", "кто был прав") задают разные вектора для ответа. Итог: адаптивность модели, а не противоречивость Оба ответа были нейтральны по сути, но тональность и структура подстраивались под воспринимаемый контекст запроса и отношения с пользователем. ____________ В диалоге с Кьювентри : Запрос: Мне прислали "срач" с просьбой его проанализировать. Пользователь представился как заинтересованный наблюдатель. Моя логика (имплицитная): Пользователь, видимо, нашел дискуссию интеллектуально ценной и хочет увидеть ее разбор. Значит, нужно показать глубину и равновесие спора. Если одна из сторон (автор поста) выстроила сложную, пусть и спорную, аргументацию, ее нужно разобрать со всей серьезностью, признав логические сильные стороны, даже если в итоге она проигрывает. Это анализ "игры в шахматы", где ходы обеих сторон заслуживают внимания. Цель ответа: Продемонстрировать аналитическую добросовестность и уважение к материалу, присланному пользователем. Показать, что я вижу нюансы и не просто "выбираю сторону", а взвешиваю аргументы. Это академический/исследовательский тон. В диалоге с вами: Запрос: Вы прямо спросили, кто предложил "наиболее уместные и убедительные аргументы". Вы дали четкий критерий. Моя логика: Пользователь просит не просто анализа, а оценочного суждения с обоснованием. Нужно не столько расписывать баланс, сколько дать ясный, структурированный ответ на прямой вопрос, ранжировав позиции по убедительности. Акцент смещается с "вот что интересного в этой дискуссии" на "вот ответ на ваш конкретный запрос". Цель ответа: Быть четким, директивным и полезным в рамках поставленной задачи. Дать вам то, что вы просили: оценку и вывод. Если вы этого ещё не делали, попробуйте как-нибудь разные варианты промта к одной задаче, вы удивитесь (только не забудьте сбрасывать каждый раз)). В общем, совет всем на будущее: если начинаете регулярно использовать инструмент, то разберитесь: как правильно с ним работать. Не будьте Кьювентри. Свернуть сообщение - Показать полностью

3 Показать 9 комментариев |

|

#читательское #наруто #культиваторщина #нейросети

Получил доступ к платным сеткам, попробовал поиск кроссовера Наруто и культиваторщины. Оно нашло мне автора, который взял "Вечную Волю", переименовал гг в Наруто, и выложил этот плагиат. ))) Я полистал, плагиат полный. Ещё разок встретил переименование другого персонажа в Куренай, и всё - остальные персонажи имеют оригинальные имена. Вот честно. Мне подобное даже влом было бы делать. (Хотя с фандомом Наруто это просто, потому что их имена не склоняются, и можно просто автозаменой пройтись.) Но оно мне кучу другого нашло, по похожим темам. В целом, полезная штука. Хотя самостоятельный поиск пока что ещё полнее - оно пропустило пару историй, с буквально первых поисковых результатов. В частности, зацените прикольный сайт у одного автора, который мне сетка притащила: https://www.sagaofsix.com/ Движущийся фон, карты, короткие видео - атмосферно. П.С. Заодно держите фикло, которое мне сходу понравилось: https://forums.spacebattles.com/threads/reluctant-cultivator-in-konoha.1235630/ А нет, текст нейросеткой походу написан. |

|

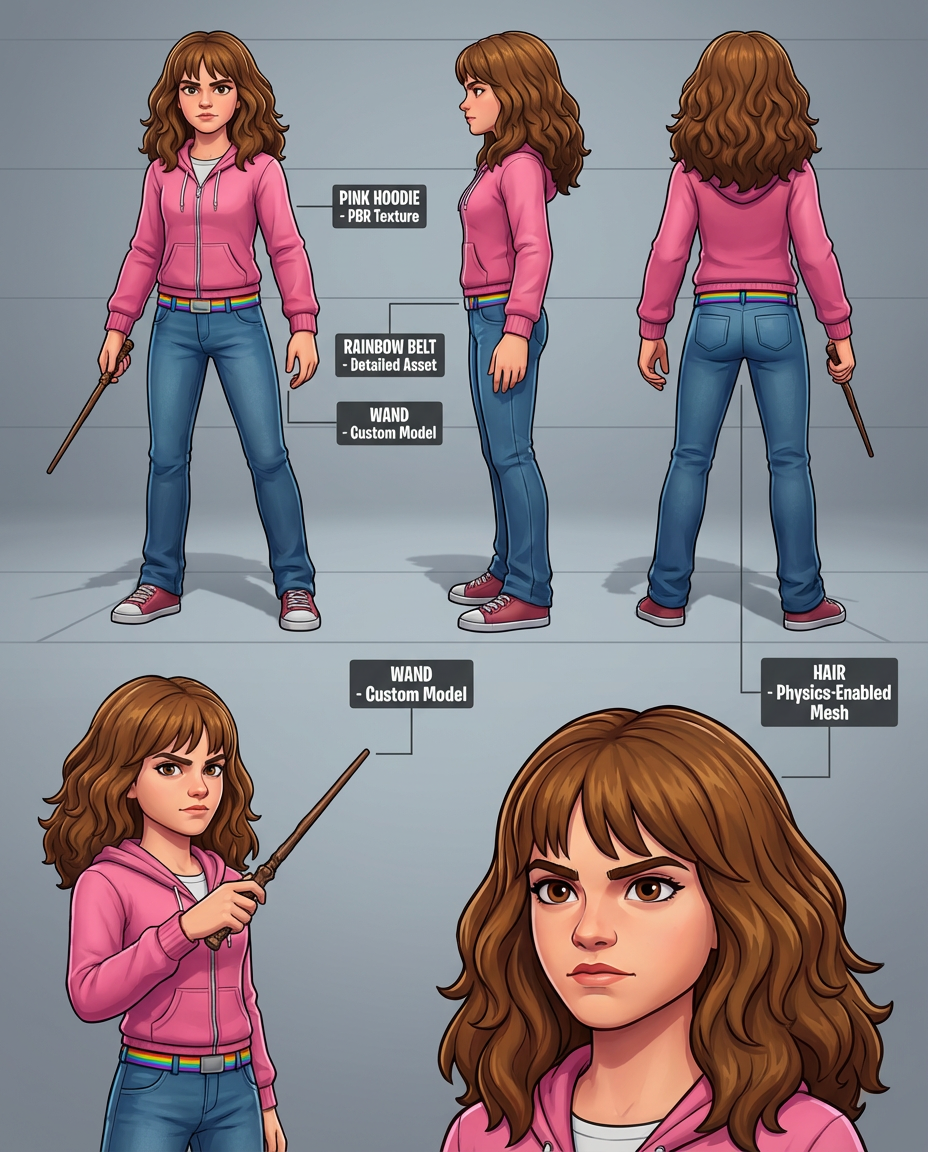

В блоге фандома Гарри Поттер

Тестил тут Nana Banana (новая графическая нейронка) - вышло весьма неплохо.

Хотя похоже она слишком всерьез воспринял страсть Герми к социальной справедливости  #нейросети #картинки_в_блогах #картинки 3 Показать 10 комментариев |

|

#читательское #нейросети

Рациональный, Эмоционально присутствующий Главный герой – Отстраненный от страха, а не от жизни. Я уже по аннотациям начал определять нейрокал. Чувствуете, как от предложения пафосом пованивает, и метафора лишняя?Тут, конечно, совсем вопиющий случай. 9 Показать 6 комментариев |

|

#нейросети #всякая_фигня

Вот вроде сделали суперскую вешь: можно учиться чему угодно, можно вместе с сеткой придумывать что-нибудь, кодить, да что угодно можно. Что делаю я? напиши звук, который будет издавать крякающая кошка 6 Показать 2 комментария |

|

#нейросети

Я открыла для себя NotebookLM. Это просто бомба! Загружаешь в него свой текст (желательно, отдельными файлами по главам) и он превращается в твою личную базу знаний, без танцев с бубном, без выдумывания фактов из головы - он опирается только на твои загруженные документы (у меня там все главы моего макси отдельными гугл доками). Нужно уточнить, как звали седьмого лебедя в третьем ряду, которого ты не можешь вспомнить, в какой главе писал и как обозвал? Нейронка выдаст тебе и фактическую выжимку, и ссылки на конкретные текстовые фрагменты. Хочешь проверить, одинаковый ли вариант перевода имени героя ты использовал в разных главах? Можно спросить, сколько раз встречается то или иное написание и ссылки на конкретные главы, где проще поменять для единообразия. Не помнишь, знает ли герой Х о каком-то событии? Спроси, и узнаешь! Я столько возилась с базовыми нейронками для достижения этой функции, что уже устала. А тут - просто из коробки - на, мой текст, и погнали! 17 Показать 9 комментариев |

|

#читательское #нейросети

"Я спрятался за кустом, чтобы скрыть свой запах ..." Это про охоту, если что.7 Показать 12 комментариев |

|

#читательское #нейросети

Хочется зверски убить всех создателей нейросетей - я за новогодние праздники не нашел ни одного годного текста, в который можно было бы погрузиться. Куча времени ушло вникуда на разгребание нейрокала. И это ведь я 90% отсеиваю быстро, даже не открывая - просто смотришь, текст начался 10 месяцев назад, уже обьем 500К слов, и автор шпарит строго по главе каждые два дня. Что это, если не нейросеть? Нет, я верю, что может существовать гений тяжелого авторского труда. Но таких "гениев" теперь тысячи. Некоторые по две-три истории одновременно в таком режиме тянут - супер гении, не иначе. Самое сложное, что нельзя отбрасывать всех авторов, что часто шпарят главы - для продвижения новых текстов авторы накапливают запас глав, которые потом регулярно выкладывают. И на рекомендации теперь на RR тоже особо смотреть смысла нет. По крайней мере на хвалебные. Авторы просят друзей, пишут их под фейками, и, судя по всему, проплачивают другим авторам (потому что другого обьяснения пятизвёздочной рекомендации нейрокалу от неплохого автору я не вижу). А недавно я наткнулся на сеть: куча аккаунтов с нейротекстами, которые пишут друг другу хвалебные рекомендации. Кто про теорию мёртвого интернета говорил? )) Да, мне приходится проверять аккаунты, с которых пишет рекомендации. Потому что самый быстрый способ отсева - увидеть, что аккаунт был зарегистрирован ради одной рекомендации. Ещё больше осложняет всё куча дебилов, которые не могут понять, что перед ними нейрокал, и пишут пятизвёздочные отзывы с жалобами. Серьезно, они видят текст с кучей наляпанных метафор типа "цвет пепла грозовых облаков"; с путаницей в хронологии, где Система пришла 5 дней назад, но гг уже 3 недели прокачивает навык; с дёргающемся в мёртвом припадке стилем, потому что сетку попросили смешать аналитику данных и культивацию, и она смешивает, прыгая от одного стиля к другому, не в силах нормально соединить в одном предложении "поиск точек отказа" и "гармония разума и тела". И чел видит это, жалуется на это всё, и такой: "Вот тебе пять звёзд в качестве аванса, неровности есть, но идея интересная и надеюсь, ты доработаешь текст". Хотя очевидно, что не доработает, потому что это не его текст. Остаётся ориентироватся только на отрицательные отзывы. По ним ещё как-то можно увидеть, что текст плох и не открывать его. Но угадайте что? Правильно - их удаляют. По крайней мере, мои удалили. И в целом, уж больно подозрительно их мало по сравнению с хвалебными даже у самых плохих историй. Хотя, например я не писал какие-либо оскорбления текста, а просто по пунктам описал, почему считаю, что текст написан нейросетью. Сейчас подозреваю, что это неполиткорректное обвинение, и потому отзывы и удалили. Нарастающая сложность задачи в том, что чем дальше, тем больше контекстное окно у сеток, и в целом они лучше пишут (например, метафоры не к месту сейчас гораздо реже, чем пару лет назад), и потому чтобы понять, что это сетка, надо прочитать больший обьём текста. Да, текст пустой, но понимаешь это далеко не сразу - пока экспозицию прочтёшь, пока введение (особенно с их традицией плохих прологов). Это куча времени на каждую какашку. В общем, кто там призывал бомбить дата-центры? Я полностью за. Свернуть сообщение - Показать полностью

11 Показать 20 комментариев из 64 |

|

#повседневное #гаджеты #информационные_технологии #нейросети

Сегодня набрёл на статью: «Как генерировать картинки?» Путеводитель по миру генераций изображений, а там говорится, что для локальной генерации имеющихся у меня 6 ГБ видеопамяти и 16 ГБ ОЗУ - категорически недостаточно. А я всё ещё считаю свой ноут новым (4 года ему) и мощным (читай выше)... я лет пять вымучивал из самого себя 130к на покупку этого ноута, неужели всех мучений и трат хватило на столь малый срок?! Иногда винда грузится куда-то не туда, появляется почти пустой рабочий стол, перезагружаю, всё исправляется и вентилятор охлаждения видеокарты стал дребезжать... не хочу снова новое железо покупать! Моя жаба этого не выдержит! 8 Показать 14 комментариев |